Damit dein Blog Post in der Google Suche erscheint, wird dein Blog regelmäßig von einem Google Bot gecrawlt. Der Bot besucht deinen Blog und scannt ihn nach neuen Links. Dabei kann es passieren, dass auch Seiten indexiert werden, die gar nicht über die Google Suche auffindbar sein sollen (z.B. dein Impressum).

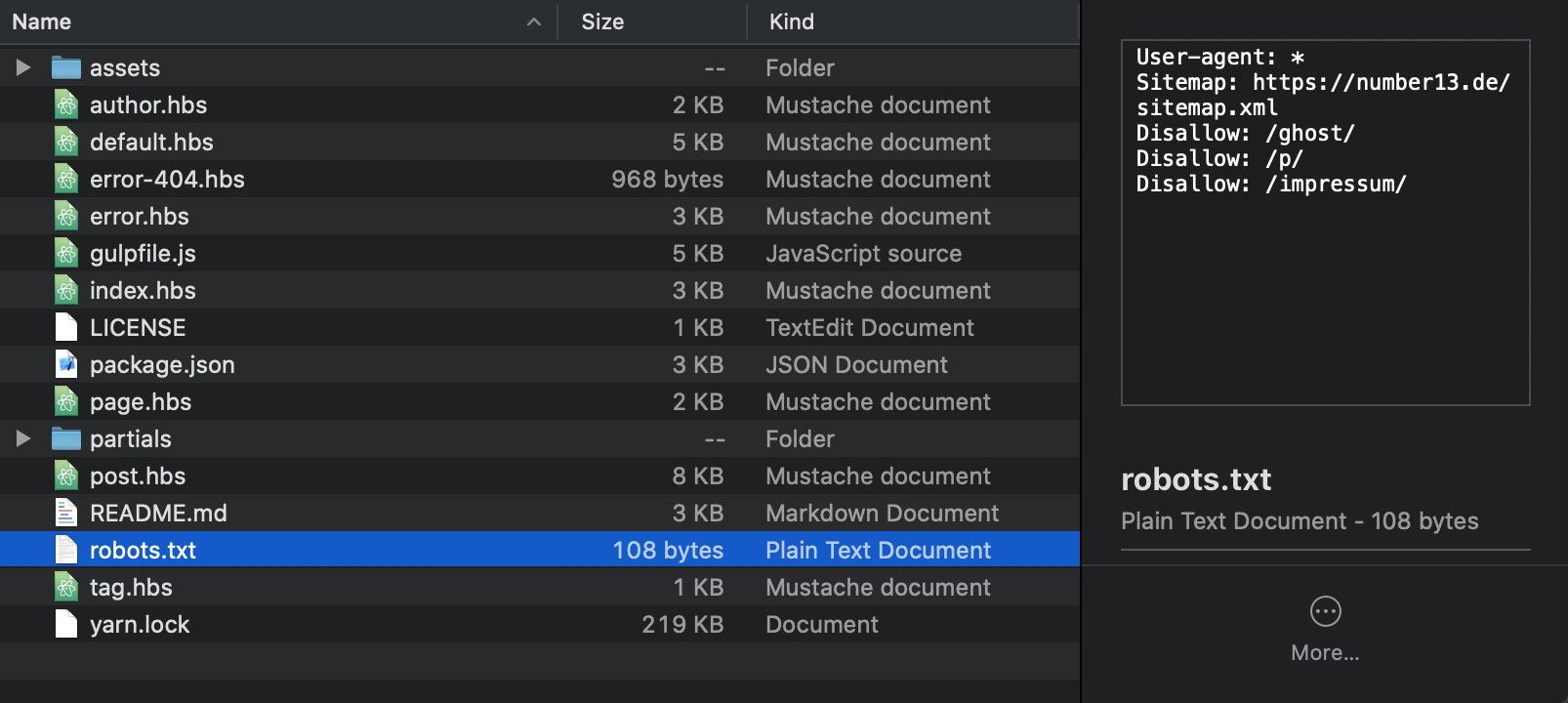

Um das zu verhindern, musst du die robots.txt Datei bearbeiten, bzw. neu erstellen. Sollte dein Theme diese Datei noch nicht beinhalten, kannst du sie einfach selbst erstellen und in das Root Verzeichnis schieben.

Die robots.txt Datei im Ghost Blog

Beinhaltet dein Blog keine selbst erstellte robots.txt-Datei, verwendet Ghost automatisch die Standardeinstellungen, die für uns wie folgt aussehen:

User-agent: *

Sitemap: https://number13.de/sitemap.xml

Disallow: /ghost/

Disallow: /p/

Hier sind die relativen Links /ghost/ und /p/ schon von der Google Suche ausgeschlossen. Um eine weitere Seite auszuschließen, musst du nur diesen Text nehmen und eine weitere Zeile hinzufügen, z.B. Disallow: /impressum/ (wie auch bei uns unter https://number13.de/robots.txt).

Wie in unserem Beispiel fügst du einfach die Textdatei in dein Theme ein. Schließlich musst du das Verzeichnis nun neu packen und erneut auf deinem Blog hochladen. Indem du https://deine-seite.de/robots.txt besuchst, kannst du überprüfen, ob die neue Robots-Datei nun auch tatsächlich live ist.

Damit sind alle Seiten unter Disallow ab sofort vom Crawlen durch den Google Bot ausgeschlossen. Sobald der Google Bot das nächste mal deine Seite besucht, wird er diese nicht mehr finden, wodurch sie von der Google Suche verschwinden.

Robots Testing Tool zum Prüfen deiner robots.txt-Datei

Mit dem Robots Testing Tool von Google kannst du leicht prüfen, ob du alles richtig gemacht hast. Dazu musst du unten nur den entsprechenden Link eingeben, und den Test starten. Sofort wird dir angezeigt, ob der angegebene Link für den Google Bot zugelassen, oder blockiert ist.

If you press this button it will load Disqus-Comments. More on Disqus Privacy: Link